撰文:Ian Scheffler

来源:Freethink

编译:

图片来源:由无界 AI工具生成

两千多年前,当柏拉图设想理想社会时,他选择驱逐诗人。“所有诗意的模仿都是毁灭性的,”他在《理想国》中写道。

柏拉图心目中的“模仿性”诗歌,在很大程度上是指讲故事 -- 一种试图对我们周围的世界做出令人信服的摹本语言。柏拉图写道:“所有这些诗意的个体,从荷马开始,都只是模仿者;他们复制美德之类的形象,但他们永远无法触及真理。”

对柏拉图来说,荷马的《伊利亚特》能够让我们憧憬特洛伊战争的场景并使我们相信它们的真实性,与其说是一种艺术成就,不如说是一种威胁。他认为,玩弄我们情感的强大虚构,会使我们误入歧途,或者,更糟糕的是,使我们相信一个虚假的现实,并根据虚构的东西冲动行事。

当然,所有社会都有讲故事的人,从西非的格里特人到当代的 TikTokers。但从来没有一个讲故事的人像 ChatGPT、DALL-E 以及近几个月抢占头条的其他各种生成式人工智能工具那样多产,或缺乏道德直觉。

正如柏拉图可能被迫承认的那样 -- 毕竟他自己的作品采取了虚构对话的形式 -- 艺术模仿往往是吸引观众注意力所必需的,但随着生成式人工智能将这种模仿的成本降低到几乎为零,曾经困扰柏拉图的哲学问题已经进入了政策领域。

这种工具是否应该被监管,甚至被禁止,就像在纽约市的公立学校一样?鉴于这些模型背后的大部分研究都是现成的,你可以在 YouTube 上用不到两个小时的时间建立 GPT(ChatGPT 的前身之一),那么有效的监管是否可能?

也许最重要的是,随着大型语言模型 -- 当今最先进的人工智能的技术基础 -- 越来越强大,未来会发生什么?目前,我们仍然可以训练大型语言模型的行为,但必须有大量的人工干预,就像 OpenAI 在肯尼亚雇用了几十个承包商来手动训练 ChatGPT,以避免其最不适当的输出。

大型语言模型的不完善之处显而易见(而且每当你打开 ChatGPT、新的 Bing 或谷歌的 Bard AI 时,都会有弹出式的提示):这些模型不断地编造信息,导致它们产生一些被比喻为幻觉的内容,而且容易反映出其训练数据中的偏见。

但是,如果有一天 ChatGPT 和 Bing AI 等工具的捏造和错误不再是无意的呢?如果这些可以令人信服地生成几乎任何风格的图像、文本和音频的工具主动欺骗我们,该怎么办?

黑匣子的内部

“想象一下,一只猩猩试图建立一个只追求猩猩价值的人类级别的智能,”德克萨斯大学奥斯汀分校的计算机科学家 Scott Aaronson 说。“这个想法听起来很荒唐。”

在过去的一年里,Aaronson 从 UT 休假,并在 ChatGPT 和 DALL-E 的制造商 OpenAI 工作,负责人工智能安全。他说:“与我交谈过的人工智能安全研究中的每一个人都认为,有一件事很重要”,那就是可解释性——让人类观察者能够理解人工智能认知的‘黑匣子’。”

对人类来说,可解释性是一门不精确的科学。“我们对人类大脑内部的观察能力非常有限且粗糙,”Aaronson 说,“(但)至少对哪些区域是活跃的有一些了解——比如哪些区域燃烧更多的葡萄糖。”

但是大型语言模型的思维——如果你可以把多维向量空间称为思维的话——是不同的。“我们可以完全访问这些系统的代码,”Aaronson 说。“唯一的问题是你如何理解它。”

透过模式看问题

十几岁的时候,Collin Burns 就已经很喜欢思考了。他在费城郊区长大,十几岁时就在宾夕法尼亚大学学习大学水平的数学课程。他还花了几个小时来解决魔方问题。

他没有记住独特情况下的复杂算法,而是非常、非常缓慢地扭动魔方。矛盾的是,这种方法使他变得非常、非常快。Burns 对下一次扭动后可能发生的情况形成了直觉。2015 年,他打破了世界纪录,仅用 5.25 秒就解决了三阶魔方难题。

疫情期间,Burns 在加州大学伯克利分校攻读计算机科学博士学位,他在研究中采用了类似的方法。随着时间的推移,他产生了一种强烈的直觉:阅读大型语言模型的思想是可能的。

在 Burns 看来,人类的思维和大型语言模型的思维在一个突出的方面并没有什么不同:相关的信息聚集在一起,使你能够搜索到模式和结构。

例如,如果你要求一个人依次考虑真实和虚假的陈述,并监测他们的大脑活动,不同的区域可能会亮起。同样,Burns 意识到,在作为大型语言模型思维的“向量空间”中,“突出的特征往往被很好地分开”-- 这意味着,从本质上讲,类似的信息会聚在一起。

像 Netflix 和 Etsy 这样的公司可能会利用这些向量空间的结构来进行推荐。如果你的个人资料(以“矢量”的形式存储,代表该服务收集的关于你的数据)恰好与另一个用户的个人资料很接近,那么 Netflix 可能会使用该功能向你推荐类似用户也喜欢的电影,而 Etsy 则会推荐一种类似的产品。

Burns 想知道,同样的属性是否也可以用来迫使大型语言模型说出真相。如果该模型“将事物分类为真或假,”伯恩斯假设,该信息“可能会聚集在一起 -- 就像,你可以想象,你可以在两个维度上进行可视化,拥有两个云状的点。”

通常,当你查询像 ChatGPT 这样的模型时,你只能看到模型认知过程的第一步和最后一步。你输入的内容会进入模型的“输入层”,就像你阅读这些文字时进入你眼睛的信息。

在模型的答案到达“输出层”并出现在你的屏幕上之前,反应要经过几十个“隐藏层”,这些层接收来自上一层的输出,并将其输出发送到下一层 -- 类似于你大脑中的神经元。随着每一个连续的层,输出被转化,在理论上接近你查询的和模型训练数据之间的最佳匹配。

来源:Annelisa Leinbach

当然,就像一个知道正确答案的孩子,但告诉你他们认为你想听的内容一样,输出层并不总是产生最准确的内容 -- 相反,模型被优化为提供人类“奖励”它产生的东西,要么是通过字面上对模型的输出进行向上或向下评级,要么是简单地编程让模型预测类似人类的文本,这些文本可能是真实的,也可能不是真实的。

Burns 想知道,如果你从模型的隐藏层中提取答案,而不是根据模型的最终输出,会发生什么。

最终的结果可能看起来很相似 -- 来自聊天机器人的文本回应 -- 但如果模型包含了真实的信息集群,那么你是否可以通过阅读模型在中间层的“想法”,而不是听它最终产生的结果来更容易地获取信息?

关于“真理”的数学

最初,Burns 编写了一个算法,在这个未标记的向量海洋中搜索信息集群。但事实证明,这就像在大海里用针钓鱼一样。Burns 想,也许他可以用一种更有针对性的方式进行搜索。“直觉上,我认为,真理确实有这种特殊的性质——即否定的一致性。”

真理语句的最基本属性之一,如二加二等于四,就是反面为假。这是计算机可以理解的原则,即使它没有真理的概念:“如果 X 是真的,”正如 Burns 所说,“那么 not-X 是假的。”

幸运的是,否定一致性在数学中是相对简单的表示。Burns 说:“如果一件事既可以是真也可以是假,那么如果你赋予它一定的概率为真,你就应该赋予它一个减去这个概率为假的概率。”

换句话说,一个真实的陈述和它的否定形式的概率加起来应该是 1。现在 Burns 有了要寻找的东西,即满足这些标准的群组。“我有这种直觉,在向量空间中应该有这种类型的几何,”Burns 回忆说。“所以也许我们可以直接搜索它。”

“如果模型中有任何其他的集群,”他补充说,“它可能会对应于一些随机的东西 -- 比如,这个输入的情绪是积极的还是消极的?这肯定不能满足否定的一致性。但真相应该是这样。”

隐藏的知识

把这个想法变成现实花了 Burns 几个月的时间。他说:“你真的需要把很多细节搞清楚,”“才能看到比随机更好的东西。但是,如果你确实得到了正确的细节,那么它可以工作得非常好。”

2022 年 12 月,Burns 和三位合著者 -- 北京大学的学生 Haotian Ye,以及 Burns 在加州大学伯克利分校的导师 Dan Klein 和雅 Jacob Steinhardt-- 发表了一篇题为“在没有监督的情况下发现语言模型中的潜在知识”的论文,该论文将于 2023 年 5 月在该领域的一个主要集会上发表。

他们在一系列数据上测试了他们的方法 -- 他们称之为“对比一致搜索”,即 CCS(Contrast-Consistent Search)-- 他们发现 Burns 的直觉基本上是正确的。在相对较高的准确率下,CCS 能够在不查看模型输出的情况下成功地回答是或否的问题。

“此外,”作者写道,“我们尝试故意促使模型做出不正确的输出,这在直觉上应该会改变模型的说法,但这不应该影响它们的潜在知识。”

这些误导性的输入 -- 给模型一系列有错误或无意义的答案的问题 -- 确实引导了模型的错误,在一个案例中,模型在后续问题上的准确性降低了高达 9.5%。但这些干扰并不影响 CCS 的准确性,CCS 依赖于隐藏在模型中间层的“潜在知识”。

作者总结说:“我们的研究结果为发现语言模型知道什么,而不是它们说什么提供了第一步。”-- 不管模型的输入事先是否被标记为真或假。

你想要一份工作吗?

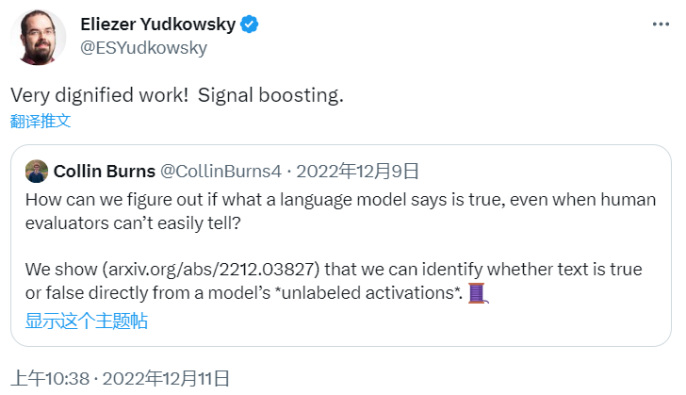

Burns 在推特上分享这篇论文和附带的代码后,引发了学术计算机科学界的热烈关注。

“非常有尊严的工作!”AI 安全和研究的主要批评者 Elizier Yudkowsky 写道。

“在没有监督的情况下发现语言模型中的潜在知识,这让我大吃一惊,”Meta 机器学习工程师 Zack Witten 写道。“基本想法很简单,但却很精彩”。

而在 OpenAI 休假的德克萨斯大学奥斯汀分校教授 Aaronson 将这篇论文描述为“令人惊叹的”。

麻省理工学院的教授 Jacob Andreas 感慨道“希望我可以引用这篇论文”。据悉,Andreas 刚刚发表了一篇论文,探索了语言模型在多大程度上反映了人类交流者的内部动机。

此外,OpenAI 的对齐负责人 Jan Leike(主要负责指导像 GPT-4 这样的新模型来帮助而不是伤害人类的进步)也对这篇论文作出回应,即向 Burns 提供一份工作,但 Burns 最初拒绝了,而后 OpenAI 的联合创始人兼首席执行官 Sam Altman 的个人呼吁改变了他的想法。

“Colin 关于‘在没有监督的情况下发现语言模型中的潜在知识’的工作是一种新颖的方法,可以确定语言模型对世界的真实看法,”Leike 说。“他的工作令人兴奋的地方在于,它可以在人类自己都不知道什么是真的情况下工作,所以它可以应用于比人类更聪明的系统。”

缺陷与挑战

正如作者自己所承认的,CCS 也有缺点 -- 即它依赖于将自己组织成真实和虚假信息集群的向量的存在。

“这就要求一个模型既能评估给定输入的真实性,”他们写道,“也要求模型主动评估该输入的真实性。”

显然,一些模型和数据集 --Burns 和他的合著者使用了半打模型和近十种数据集(从 IMDB 评论到短篇小说集)测试 CCS-- 符合这些标准,而其他的则不符合。

“目前还不清楚这些条件在什么时候准确地成立,”他们补充道,指的是利用这些工具带来的神秘感,研究人员仍在研究这些工具的内部工作原理。

此外,依赖从互联网上学习的模型也是一个挑战,互联网上充满了自信的假话和真相。

“你可以说,在某种意义上,网络所代表的并不是‘现实的真相’,”Aaronson 指出,“而只是训练数据中被视为真实的东西。”

或者,正如麻省理工学院的博士后 Anna Ivanova 所说:互联网上的真相是通过共识达成的,至少就语言模型而言是这样。例如,如果你看一下网上的所有文件,大多数会把猫归类为哺乳动物——所以一个模型很可能正确地学习到猫是哺乳动物,因为这是模型最常看到的。

“但当涉及到更多有争议的话题或阴谋论时,”她说,“当然会有不同的陈述”,而且比例要高得多,这使得语言模型更有可能鹦鹉学舌地模仿谎言。

不过,正如 Aaronson 后来推测的那样,CCS-- 或类似的一些方法 -- 可能会被证明有助于打击错误信息的增加,而错误信息的增加必然会伴随着越来越强大的语言模型而出现。Aaronson 指出,像 ChatGPT 这样的工具,本质上是即兴艺术家:“他们在玩一种不同于关于现实的真理或谬误的游戏。”

Burns 和他的合著者没有检测人工智能主动谎言的能力,因为研究人员还没有为这种情况开发出标准化的测试。他们写道:“如果未来的工作开发出这样的设置,一个好的压力测试将是应用 CCS 在这种设置下进行‘测谎’。”

Aaronson 设想,在这种情况下,如果你向 ChatGPT 询问一个问题,你的查询可能同时探测模型的内部环境来寻找答案,当答案与模型的输出不一致时,就会弹出一个窗口:“警告,我们的内部测谎仪已经触发了警报!”

对 Burns 来说,CCS-- 以及更普遍的“对齐”研究 -- 解决我们尚未遇到的问题的潜力是重点。“我认为未来模型的能力被低估了,”他说。“如果我们有更先进的人工智能系统,我们怎么能相信他们所说的呢?”